22:28 Как A/B-тестирование может привести к резкому падению конверсии | |

Сплит-тесты помогают оптимизировать конверсию. С их помощью маркетологи проверяют эффективность изменений посадочных страниц, конверсионных форм и других элементов сайтов. Однако A/B-тесты могут приводить к резкому падению коэффициента конверсии и сокращению продаж. Как это происходит? Читайте ниже.  В чем смысл сплит-тестирования

В чем смысл сплит-тестирования

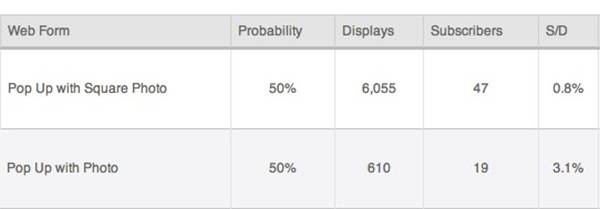

A/B-тест — это исследовательский способ, позволяющий оценивать эффективность изменений на сайте. Одновременно сплит-тест является прикладным маркетинговым методом повышения эффективности веб-страниц. A/B-тестирование выполняется с помощью специальных сервисов, например, Content Experiments, Visual Website Optimizer или Optimizely. Суть A/B-теста заключается в следующем: Очень часто результаты сплит-тестов оказываются неожиданными. Например, коэффициент конверсии может вырасти после удаления со страницы отзывов благодарных клиентов, а число заказов может увеличиться после замены агрессивного CTA «Подпишитесь на рассылку прямо сейчас» на нейтральный текст «Хочу получать информацию о новых товарах и скидках». Иногда A/B-тест не просто фиксирует неэффективность изменений, а приводит к негативным результатам для бизнеса. Это случается из-за маркетинговых или технических ошибок. Как сплит-тест может обрушить конверсию: мини-кейсВладелец популярного англоязычного блога об интернет-маркетинге решил проверить эффективность всплывающей формы подписки на email-рассылку. Он создал тестовый вариант формы подписки и поровну распределил трафик между контрольной и тестовой формами с помощью сервиса AWeber. Спустя сутки блоггер проверил результаты эксперимента. В отчете он увидел следующую картину:

В верхней строке отображаются результаты тестового варианта, а в нижней контрольного. Результаты тестирования требуют расшифровки: Не нужно иметь ученую степень, чтобы понять, что результаты теста нельзя считать валидными. Несмотря на планы экспериментатора распределить трафик поровну между тестовой и контрольной страницей, вариант с изменениями набрал почти в 10 раз больше просмотров. Как оказалось, это произошло из-за технического сбоя на платформе AWeber. Казалось бы, владелец блога может перевести дух, дождаться сообщения об устранении неполадок и заново запустить эксперимент. Но здоровая придирчивость может заставить его еще раз посмотреть на соотношение S/D базовой страницы и число показов тестовой страницы. Черт возьми, если бы платформа сломалась в другую сторону, то 6055 показов могли конвертироваться в 187 подписок. Осознав потерю сотни подписчиков за сутки, блоггер может сильно расстроиться и потерять веру в сплит-тестирование. На самом деле, от технических сбоев никто не застрахован, а A/B-тесты остаются эффективным маркетинговым средством, несмотря на описанный выше казус. Однако сплит-тесты могут показывать ошибочные результаты и приводить к падению конверсии из-за маркетинговых ошибок. Когда сплит-тесты приводят к потерям по вине экспериментатораЭксперимент становится проблемой для сайта и бизнеса, когда маркетолог допускает серьезные ошибки на стадии планирования. Ниже описаны наиболее распространенные ошибки экспериментаторов. Как вы думаете, какой текст станет более конверсионным: «добавить товар в корзину» или «оформить заказ»? Ответ на этот вопрос можно получить в ходе сплит-теста. А какой CTA окажется более удачным для формы подписки: «подпишись на нашу рассылку» или «оставь Email и получи 1000 рублей на счет Webmoney»? Вы знаете ответ на этот вопрос без A/B-теста.

Проблема не в том, что результаты эксперимента будут искажены. 99 % подписчиков, подписавшихся ради 1000 халявных рублей, отпишутся от вашей рассылки в течение нескольких дней. Они не сделают этого сразу же после получения денег только из-за опасений, что вы будете сниться им по ночам и качать головой с упреком. Получается, данная ошибка опасна не столько из-за искажения результатов эксперимента, сколько из-за получения ложных конверсий. Многие сервисы для проведения A/B-тестов позволяют произвольно определять долю трафика, участвующего в эксперименте. Если вы допускаете к участию в эксперименте незначительное количество посетителей, это значительно увеличивает сроки, необходимые для получения валидного результата. Но это еще не все. Представьте себе следующую ситуацию: вы тестируете новый дизайн страницы. В эксперименте участвует 5 % посетителей, которые направляются на тестовую страницу. Вы никуда не спешите, поэтому не хотите рисковать. Через месяц выясняется, что коэффициент конверсии тестовой страницы в 2,5 раза превышает аналогичный показатель контрольной. Вывихнутое в попытке укусить себя за локоть плечо ничего не значит по сравнению с недополученной прибылью. Потери можно было бы значительно сократить, распределив трафик иначе в начале эксперимента.

Представьте, что вы тестируете новый вариант текста для конверсионной кнопки. В последний момент дизайнер решает еще и изменить цвет самой кнопки на тестовой странице. В ходе эксперимента выясняется, что новая страница является в два раза более конверсионной по сравнению со старой. Вы приписываете этот эффект новому тексту и удаляете старый вариант. Спустя некоторое время вы замечаете, что конверсия страницы упала на 50 %. Поймав в курилке дизайнера, вы выдавливаете из него чистосердечное признание об изменении цвета кнопки. Теперь вы можете объяснить рост конверсии в ходе теста. Более того, вы понимаете, что потеряли время и клиентов, так как новый текст конверсионной кнопки оказался менее эффективным по сравнению со старым. Представьте, что вы тестируете эффективность конверсионных кнопок, приглашающих пользователя скачать бесплатную электронную книгу. В данном случае конверсией можно считать клик по кнопке, после которого книга начинает автоматически загружаться на жесткий диск посетителя. Вы будете оценивать результаты теста по CTR каждого варианта кнопок. А как оценить эффективность конверсионной кнопки, приглашающей добавить товар в корзину или оформить заказ? Клик по кнопке не равен конверсии, так как добавив товар в корзину, пользователь может передумать. Возможно, эффективность кнопки стоит оценивать по количеству завершенных сделок? Возможна ли ситуация, когда кнопка с более высоким CTR генерирует меньше завершенных сделок? Нанесет ли ущерб бизнесу ситуация, в которой вы ошибочно считаете более эффективной кнопку с высоким CTR и низким показателем оплат?  Сильное лекарство в руках неопытного, как острый меч в руках безумца

Сильное лекарство в руках неопытного, как острый меч в руках безумца

Врачи древности предостерегали этими словами начинающих коллег от бездумного использования лекарств. A/B-тест — это сильное маркетинговое лекарство, которое приносит пользу только при правильном применении. Ошибки сплит-тестирования могут стоить вам не только потерянного времени, но и падения конверсии и продаж. Будьте внимательны! Адаптация материала How A/B Testing Can Lead to a Dramatically Lower Conversion Rate, What’s Wrong With A/B Testing, Three Common Ways A/B Testing Goes Wrong и другие. Читайте также: | |

|

| |

| Всего комментариев: 0 | |